Das PDF dient ausschließlich dem persönlichen Gebrauch! - Weitergehende Rechte bitte anfragen unter: nutzungsrechte@asu-arbeitsmedizin.com.

From human risk factor to human safety factor

This article explores the shift from a failure-oriented to a capability-oriented understanding of safety in complex systems. Traditional approaches focus on human error as the main cause of incidents, while the text advocates for a systemic view aligned with Safety-II. Safety is seen as the ability to succeed under varying conditions, with resilience as a key competence. Methods such as Functional Resonance Analysis Method (FRAM) and Crew Resource Management (CRM) offer practical approaches to analyzing and shaping resilient processes. Thus, the human is reframed – not as a risk factor, but as an essential contributor to safe performance especially in complex environments.

Vom Risikofaktor Mensch zum Sicherheitsfaktor Mensch

Der Beitrag beleuchtet den Wandel von einer fehlerorientierten zu einer fähigkeitsorientierten Sicht auf Sicherheit in komplexen Systemen. Während klassische Ansätze menschliches Versagen als Hauptursache für Zwischenfälle fokussieren, plädiert der Text für ein systemisches Verständnis im Sinne von Safety-II. Sicherheit wird als Ergebnis gelingender Alltagsbewältigung verstanden, Resilienz als zentrale Fähigkeit. Ansätze wie Functional Resonance Analysis Method (FRAM) und Crew Resource Management (CRM) zeigen praxisnahe Wege zur Analyse und Gestaltung resilienter Prozesse. Damit wird der Mensch nicht länger als Risikofaktor, sondern als aktiver Gestalter sicherer Leistung betrachtet – gerade unter Bedingungen hoher Komplexität.

Kernaussagen

Sicherheit als Abwesenheit unerwünschter Ereignisse

Betrachtet man die Statistik der Verkehrstoten in Deutschland über den langen Zeitraum 1950 bis 2020, so nimmt deren Zahl seit 1970 stetig und bedeutsam ab. Vergleichbare positive Langzeittrends zeigen sich vielerorts. Für die Medizin weist beispielsweise Staender (2024) auf langfristige Verbesserungen in der Vermeidung von anästhesiologischen Todesfällen hin. Diese Erfolgsgeschichte beruht auch auf einigen – zumeist unausgesprochenen – grundlegenden Überzeugungen. Diese sind gültig, solange Rahmenbedingungen stimmen. Erfolg ist demnach nicht automatisch gegeben, sondern abhängig davon, dass geeignete Umstände bestehen. Zu diesen Rahmenbedingungen gehört die Wirksamkeit der Idee, dass schlechte Ursachen schlechte Folgen haben. Das Versagen eines Systems ist somit erklärbar durch einen Fehler in einer Komponente. Eine weitere Überzeugung ist die Idee, für Ereignisse retrospektiv deren endgültige Ursache finden zu können („root cause analysis“). Dieser Artikel argumentiert gegen die ungebrochene Gültigkeit solcher Überzeugungen unter bestimmten Bedingungen und thematisiert einen alternativen Ansatz. Um nicht falsch verstanden zu werden: Es wird nicht argumentiert, dass diese Konzepte falsch seien. Es wird vielmehr argumentiert, dass, bei Abwesenheit bestimmter Voraussetzungen, ihre Nützlichkeit stark eingeschränkt ist. Bevor dies im weiteren Verlauf des Textes näher ausgeführt wird, soll zunächst im Folgenden der Begriff „Human Error“ näher betrachtet werden.

Human Error

Human Error („Menschlicher Fehler“) ist der Titel eines bekannten Werks von Reason (1990). Gemeint sind damit Handlungen oder Unterlassungen, die eine geplante Abfolge von Aktivitäten nicht wie beabsichtigt verlaufen lassen und dadurch ein unerwünschtes Ergebnis herbeiführen oder potenziell herbeiführen können. Das Buch liefert eine einflussreiche Typologie menschlicher Fehler und analysiert deren Bezug zu menschlichen Denkprozessen („cognitive processes“). Der Autor vertritt die Auffassung, dass Fehler ein integraler und unvermeidbarer Teil menschlichen Verhaltens sind. Zur Anwendung kam diese Perspektive unter anderem bei der retrospektiven Aufarbeitung einer Reihe katastrophaler Unfälle in den 70er und 80er Jahren. Dies führte zu der Einsicht, dass häufig individuelle Fehler, fehlerinduzierende Zustände und Design-Mängel zusammenwirken, um unerwünschte Ereignisse zu produzieren (Reason 1997). In der Medizin erschien in den USA, ganz in diesem Sinn, der ebenfalls vielbeachtete Report „To err is human“ (Kohn et al. 1999) über notwendige Veränderungen im Bereich der Patientensicherheit.

Das Konzept der Fehleranfälligkeit des Menschen ruht selbst auf Vorarbeiten aus Anthropologie und Psychologie. Arnold Gehlens zuerst 1940 erschienenes Buch „Der Mensch: Seine Natur und seine Stellung in der Welt“ (Gehlen 2009, 14. Auflage) charakterisiert den Menschen als biologisches „Mängelwesen“, das im Gegensatz zu den Tieren nicht an eine bestimmte Umwelt angepasst und zugleich durch einen schwerwiegenden Mangel an echten Instinkten charakterisiert ist. In der Psychologie zeigt die empirische Laborforschung zu Denkprozessen allgemeine Schwachstellen auf: So findet Miller (1956) zum Beispiel eine Begrenzung des Fassungsvermögens des menschlichen Arbeitsgedächtnis und Tversky u. Kahnemann (1974) identifizieren sogenannte Heuristiken1 beim Urteilen und Problemlösen als Fehlerursache. Beide Arbeiten gehören mit zehntausenden von Zitationen zu den meistbeachteten Publikationen in der Psychologie. Die Fehlerforschung findet schließlich in empirischen Feldstudien den menschlichen Fehler als Ursache für 80–90 % aller Zwischenfälle. Ein Beispiel dafür in der Medizin (Radiologie) ist Martin (2005).

Damit liefert der Human-Error-Ansatz ein zwiespältiges Bild. Zum einen wird die Bedeutung des menschlichen Fehlers herausgestellt, zum andern wird auf seine Abhängigkeit von zahlreichen weiteren Faktoren verwiesen. Dies mag theoretisch richtig sein – ist es aber auch produktiv? Neuhaus et al. (2022) unternehmen diesbezüglich eine umfangreiche Literaturanalyse des Einflusses des Reports „To err is human“ auf die medizinische Fachliteratur im Bereich Anästhesiologie. Sie finden, dass die Forschung zur Patientensicherheit durch Kliniker sich letztendlich um den menschlichen Fehler dreht („… just another attack on human error …“) und es eben nicht gelang, einen systemischen Ansatz in der Gesundheitsversorgung zu etablieren. Im folgenden Abschnitt wird für dieses Phänomen eine Erklärung angeboten.

Herausforderung Komplexität

„Komplexität“ ist als Begriff aus der neueren Fachliteratur zur (Patienten-)Sicherheit nicht mehr wegzudenken. St. Pierre u. Hofinger (2020, S. 37) sehen die Akutmedizin als „komplexes System“, Burghofer u. Lackner (2022, S. 52) bescheinigen ihr eine „immense Komplexitätssteigerung“, Sujan (2021, S. 103) benennt „the complexity of everyday clinical work“ und Woods u. Cook finden schließlich bereits früh (2001, S. 91): „the enemy of safety is complexity“.

Die Frage, was diese Komplexität genau sei, wird jedoch selten gestellt. Mühlbradt u. Unger (2024) zufolge ist Komplexität keine Eigenschaft soziotechnischer Systeme, sondern ein relationales Phänomen: Sie wird einerseits von den Akteuren im System erlebt, wenn Transparenz, Erklärbarkeit und Vorhersagbarkeit in Planungs- und Entscheidungssituationen fehlen. Andererseits zeigt sich Komplexität auch im situativen Handeln dieser Akteure, das durch emergente Regeln2 und ein Streben nach Resilienz geprägt ist. Dieses Verhalten führt wiederum bei externen Beobachterinnen und Beobachtern des Systems zum Erleben von Komplexität, da ihre mitgebrachten Vorstellungen vom System unzureichend sind.

Das Erleben von Komplexität ist aus dieser Sicht nicht schicksalhaft: Es wäre durchaus möglich, Systeme und deren Umgebungen so einfach zu gestalten, dass sie nicht erlebt wird. Allerdings benennt bereits Perrow (1984, S. 89) das damit einhergehende Problem: Es gibt komplexe Systeme, weil man nicht weiß, wie man deren Leistung alternativ durch einfache Systeme erbringen könnte.

Die Zunahme an Komplexität ist nur bis zu einem gewissen Punkt eine graduelle Veränderung. Ab einem gewissen Grad an Komplexität sind vielmehr grundsätzlich andere Herangehensweisen, unter anderem an Prozessanalyse und -gestaltung erforderlich. Stanton et al. (2019) postulieren daher für die Unfallforschung einen grundlegenden Paradigmenwechsel hin zu einem systemischen Verständnis. Diesem Gedanken folgen die weiteren Abschnitte.

Sicherheit als Anwesenheit von Fähigkeiten

Eine neue Sicht auf Sicherheit

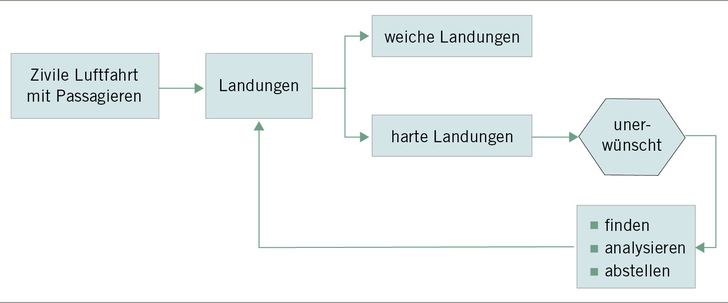

Auf einer Konferenz in Gloucestershire im Jahr 2020 verwendete der dänische Psychologe Erik Hollnagel das in ➥ Abb. 1 gezeigte Beispiel. Die zivile Luftfahrt transportiert Passagiere. Alle Flüge enden mit der Landung, wobei gute (ruhig, kaum merklich) und schlechte (laut, spürbar, beängstigend) Landungen unterschieden werden können. Da schlechte Landungen auch schlecht für die Kundenzufriedenheit und damit das Geschäft sind, strebt die Fluggesellschaft danach, solche Landungen zu finden, sie zu analysieren und endlich abzustellen.

Die Idee dabei ist, dass Fehler Abweichungen vom guten Standard („gute Landung“) sind. Gemäß der impliziten Überzeugung, dass schlechte Folgen auf schlechten Ursachen beruhen, führt das zu einer Fixierung auf Fehler: Wenn es nur gelänge, die Fehler abzustellen, würde anschließend der Standard der weichen Landung herrschen. Da dieser Standard bekannt ist und in der Ausbildung gelehrt wird, ist er an dieser Stelle auch nicht weiter beachtenswert.

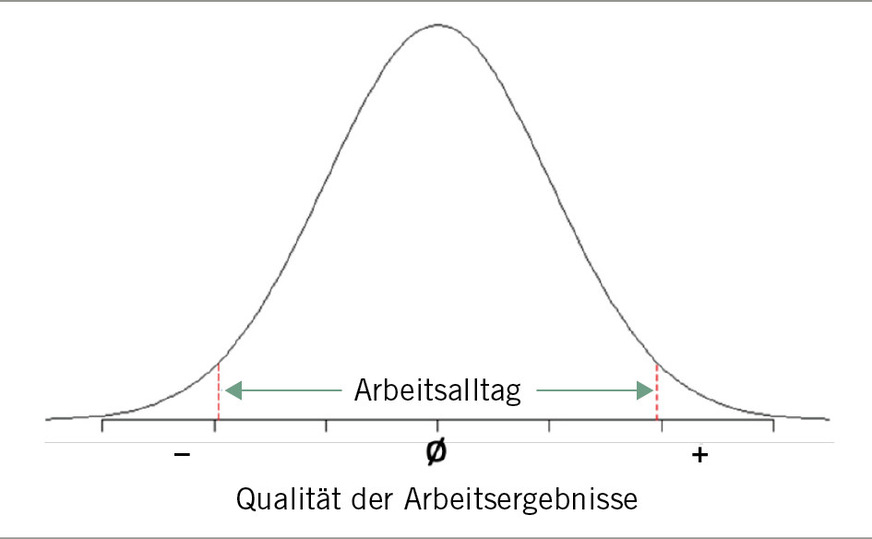

Was aber, wenn dies nur eine simplifizierende Sicht ist und in der Realität die weiche Landung ein Handeln unter sich beständig ändernden Bedingungen bedeutet und damit eine ständige Auseinandersetzung mit situativer Komplexität erfordert? Dies hat Hollnagel (2016, S. 190) im Blick, wenn er fragt: „What happens when ‚nothing‘ happens“? Damit ist gemeint, dass zwar nichts passiert im Sinne einer schlechten Landung. Das Geschehen entspricht dennoch mitnichten einfach einem Standard, sondern ist variantenreich und damit voll wertvoller Informationen. Handlungsergebnisse (viele Landungen) verteilen sich dann auf einer Qualitätsskala, wobei mittelmäßige Ergebnisse am häufigsten (Arbeitsalltag), sehr gute („exzellente Landungen“) oder sehr schlechte („Bruchlandungen“) Qualitäten demgegenüber deutlich seltener sind (➥ Abb. 2).

Werden Landungen aus dieser Perspektive betrachtet, sind die häufigen Handlungen in der Mitte der Skala viel interessanter als die seltenen Ereignisse an den Rändern. Die Fragen lauten dann: Wie gelingt es in der Vielzahl der Fälle, eine akzeptable Leistung zu erbringen? Welche wechselnden Umstände liegen vor und welche Leistungen werden erbracht auf Basis welcher Fähigkeiten? Werden diese Fähigkeiten identifiziert und gestärkt, finden mehr gute Landungen, automatisch aber auch weniger schlechte Landungen statt. Sicherheit ist hier nicht mehr die Abwesenheit unerwünschter Ereignisse – und damit die Abwesenheit von Fehlern – sondern vielmehr die Anwesenheit von Fähigkeiten, erwünschte Ergebnisse auch unter normalen, unerwarteten und auch widrigen Umständen zu erbringen. Bevor dem weiter nachgegangen wird, muss zuvor einigen Argumenten begegnet werden.

Ein erweitertes Fundament

Stehen dieser Sichtweise nicht die im Abschnitt „Human Error“ dargestellten Befunde entgegen? Dort wurden ja theoretische, methodische und empirische Argumente für eine Fehlerorientierung angeführt. Diesen Argumenten kann tatsächlich fundiert widersprochen werden. In theoretischer Hinsicht fragt die ökologische Rationalität (Gigerenzer 2024) nach der praktischen Relevanz von Laborbefunden in der Psychologie. Heuristiken sind beispielsweise in realen Situationen mitnichten fehlerhaft, sondern ein rationales Denkwerkzeug unter den herrschenden Bedingungen. Methodisch wird gefordert, über die „root cause analysis“ hinauszugehen und Variabilität stärker zu beachten (Stretton 2021). Empirisch wird der oben genannte 80 %-Ursachenanteil von Human Error kritisch hinterfragt (Besnard u. Hollnagel 2014; Wróbel 2021). Es ist daher durchaus vertretbar, über das Bestehende hinauszugehen. Safety-II strebt das an.

Konsequenzen für Analyse und Gestaltung

Safety-II

Der Begriff Safety-II wird von Hollnagel (2014) in Abgrenzung zum Ansatz Safety-I geprägt. Safety-II ist ein Sicherheitsansatz, der sich darauf konzentriert, warum Dinge gut laufen – also wie Menschen und Systeme erfolgreich mit Komplexität und

Variabilität umgehen. Während Safety-I primär auf das Verhindern von Fehlern und negativen Ereignissen durch deren Analyse fokussiert, untersucht Safety-II alltägliche Arbeitspraktiken, um Resilienz und Anpassungsfähigkeit zu fördern. Ziel ist es, Sicherheit durch das Verständnis und die Unterstützung effektiver Arbeitsweisen zu stärken. Das Konzept wird erst in jüngster Zeit im deutschsprachigen Raum breiter aufgenommen (Mühlbradt et al. 2024; Staender 2024; Gausmann 2025). Ein Schlüssel zu sicheren Abläufen ist demnach die Stärkung der Fähigkeiten auf Team- und Prozessebene zur Bewältigung der alltäglichen Komplexität. Als Alternative zur Fokussierung auf Fehler als Erkenntnisquelle erscheint dieser Ansatz auch geeignet, die intrinsischen Widersprüche von „just culture“ zu überwinden (Edwards 2018). Zentral für Safety-II ist das Konzept der systemischen Resilienz. In Abgrenzung zur psychologisch orientierten individuellen Resilienz von Personen, wird Resilienz hier verstanden als Fähigkeit von soziotechnischen Systemen, ihre Ziele auch unter widrigen und unerwarteten Bedingungen weiterhin zu erreichen.

Folgen für Analytik und Gestaltung

„Normale“ Prozesse und deren vielfältige, situative Anpassungen rücken ins Zentrum des Interesses. Für das Verständnis komplexer Prozesse werden Methoden erforderlich, die insbesondere einen Zugang zu Variabilität ermöglichen. Das kann nur gelingen, indem die Alltagserfahrungen derjenigen geschöpft werden, die diesen Prozess ganz oder teilweise alltäglich durchführen („work-as-done“). Beteiligungsorientierte Verfahren setzen darauf. Ein exemplarisches Safety-II-Werkzeug dafür ist die Functional Resonance Analysis Method (FRAM, Hollnagel 2012). Zahlreiche Anwendungen der Methode, gerade im Gesundheitswesen, liegen vor (z. B. van Dijk et al. 2022; Speer et al. 2024). Eine kurze Einführung in die FRAM in deutscher Sprache geben Mühlbradt et al. (2024).

Bei der Gestaltung von Prozessen steht die Stärkung der Fähigkeiten für resilientes Verhalten auf der Ebene von Prozessen und Teams im Zentrum. Das Crew Resource Management (CRM) spielt dabei eine wichtige Rolle. Über die akute Versorgungssituation hinaus bietet es sich als Strategie für das Leiten von Teams und Abteilungen an (Mühlbradt u. Unger 2024). Ebenfalls bedeutsam für eine erfolgreiche Bewältigung von Komplexität ist organisationales Lernen (Evenseth et al. 2022; Birkeli et al. 2025). Angefangen beim (klinischen) Debriefing, über Huddles (kurze, spontane Meetings) und Learning Teams zur Prozessverbesserung bis zur periodischen Beschäftigtenbefragung sind dafür Strategien und Methoden verfügbar.

Stillstand beim Fortschritt in der (Patienten-)Sicherheit kann überwunden werden, wenn Komplexität verstanden wird. Wenn Sicherheit nicht mehr nur die Abwesenheit von unerwünschten Ereignissen und Fehlern ist, sondern als Anwesenheit resilienzförderlicher Fähigkeiten begriffen wird, wandelt sich auch das Bild vom Menschen als Risikofaktor zum Menschen als Sicherheitsfaktor.

Literatur

Hollnagel E: FRAM: the Functional Resonance Analysis Method. Burlington: Ashgate, 2012.

Hollnagel E: Safety-I and Safety-II. Milton Park: Routledge, 2014.

Hollnagel E: Resilience engineering: a new understanding of safety. J Ergon Soc Korea 2016; 35: 185–191.

Mühlbradt T, Unger H: Was ist komplex an komplexen soziotechnischen Systemen? Tagungsband zum 70. Kongress der Gesellschaft für Arbeitswissenschaft e. V. Stuttgart, 06.–08.03.2024.

Perrow C: (1984). Normal Accidents: Living with High Risk Technologies. Basic Books.

Reason JT: Human Error. Cambridge: Cambridge University Press, 1990.

Stanton NA, Salmon PM, Walker GH, Stanton M: Models and methods for collision analysis: A comparison study based on the Uber collision with a pedestrian. Safety Science 2019; 120; 117–128.

Die komplette Literaturliste mit allen Quellen kann auf der Homepage beim Beitrag eingesehen werden (asu-arbeitsmedizin.com).

Interessenkonflikt: Der Autor gibt an, dass kein Interessenkonflikt vorliegt.

Förderhinweis: Das Projekt „Resilientes Transformationsmanagement zur Kreislaufwirtschaft in der Textilindustrie – ReTraKT“ wird im Rahmen des Programms „Zukunft der Arbeit“ (Förderkennzeichen 02L23B010 bis 02L23B014) durch das Bundesministerium für Forschung, Technologie und Raumfahrt (BMFTR) und die Europäische Union über den Europäischen Sozialfonds Plus (ESF Plus) gefördert und vom Projektträger Karlsruhe (PTKA) betreut.